在生成式AI浪潮的驱动下,算力需求将持续攀升,进而带动大型数据中心等算力基础设施规模不断扩大。中国信通院预计,2024-2028年全球算力规模将以超过50%的速度增长,到2025年全球计算设备算力总规模将超过3 ZFlops,至 2030年将超过20 ZFlops。

不过,伴随着数据中心算力需求的不断提高,其高耗能性带来的散热问题也变得更加严峻。服务器在工作的过程中,其CPU、GPU、内存、存储等器件会产生大量热量,使得芯片工作温度急剧攀升,进而影响设备工作性能,甚至导致电子设备损坏。根据DeepTech数据,当电子设备温度过高时,工作性能会大幅度衰减,当芯片的工作温度靠近70-80℃ 时,温度每升高2℃,芯片的性能会降低约10%,超过55%的电子设备失效形式都是温度过高引起的。

出于维持设备稳定运行和降低能耗的原因,任何数据中心和服务器设备都有必要配备高性能的散热器件进行降温。因此,数据中心或服务器算力的提升除依赖CPU、GPU等核心器件不断升级外,也有赖于散热技术的持续进步,AI大发展带来的算力需求攀升,必将催生巨大的散热产品需求。

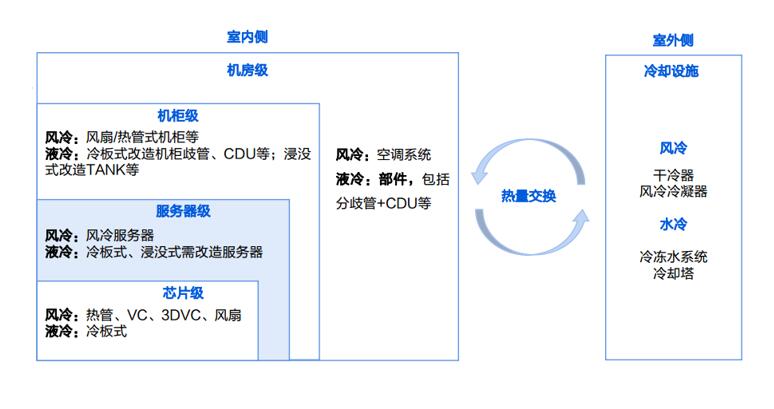

目前,数据中心的散热产品可以分为芯片级、服务器级、机柜级和机房级四个层级,四个层级的散热器件或设备共同作用、相互配合才能起到最佳的整体散热效果。

高算力需求拉动AI服务器放量,芯片级散热高增长可期

芯片级散热是通过直接在芯片或处理器表面移除热量来优化设备性能并延长使用寿命的一种散热方式。根据《数据中心服务器功耗模型研究进展》,通用服务器内CPU、内存、存储等器件功耗占比分为32%、14%和5%。但随着AI服务器的出现,CPU就成了服务器的散热“大户”。和传统服务器不同,AI服务器采用“CPU+GPU”异构结构,其迅速增长的训练推理算力需求带动AI芯片的单卡算力大幅提升,如英伟达H100 GPU功耗高达700W,最新推出的B200 GPU功耗更是达到1000W,远超CPU功耗。据公开资料,AI服务器作为人工智能发展的重要算力底座,CPU和GPU的整体功耗在AI服务器总功耗中占比达到80%左右,其中GPU功耗占服务器总功耗比重在55%左右。

随着服务器芯片功耗的不断提升,服务器芯片级散热产品也在持续进化,从早期的一维热管的线式均温发展到二维V C的平面均温,又逐步进化到3 DVC的三维散热技术。直到近年,随着AI服务器采用的GPU的功耗大幅提升,风冷技术逐渐达到散热能力瓶颈,冷板式液冷开始替代风冷成为服务器芯片级散热产品主流。

其中,热管散热通过内部工作流体的相变过程快速地将热量从一端传递到另一端, 主要用于大功率芯片及散热空间小的产品,如服务器、笔记本、 游戏机、 VR/AR、通信设备等场景;VC均温板的散热原理与热管类似,但它打破热管的一维散热模式,形状则不受限制,可以根据芯片的布局设计任意形状,甚至可以兼容处于不同高度的多个热源的散热,是一种比热管更先进、更高效的导热元件;3D VC则是利用热管与均温板蒸汽腔体贯通的散热技术,它是把热量传递至二次组装的多根热管/均温板,通过三维结构连通下,内部液体相变、热扩散,直接、高效地将芯片热量传递至齿片远端散热,可满足大功率器件解热、 高热流密度区域均温的瓶颈需求。

在业内,热管、VC、3DVC可结合风扇组合使用,均被归属为风冷散热范畴,英伟达的DGX A100服务器采取的就是风扇+3D VC的风冷散热方式。不过,由于热管/VC等产品散热范围有限,已逐渐退出主流服务器散热产品行列。 3D VC虽然散热性能大幅提升,但为在服务器芯片功耗持续增加的情况下,也只能作为风冷向液冷发展的过渡产品,冷板式液冷才是服务器芯片级散热的未来。

冷板式液冷是一种基于微流控技术的液冷系统,它通过在散热器表面形成一层微型通道,将液体通过管道喷射到散热器表面,然后通过蒸发和凝结来吸收和散发热量,优点是可以实现高效的热传递和精准的温度控制,适用于需要高精度冷却的高性能计算、服务器等高功率领域。由于冷板式液冷的冷却液不与服务器元器件直接接触,又之为间接液冷。

依据冷却液在冷板中是否发生相变,冷板式液冷可分为单相冷板式液冷及两相冷板式液冷。其中,单相冷板式液冷采用泵驱动冷却液流过芯片背部的冷板通道,冷却液在通道内通过板壁与芯片进行换热带走芯片的热量,换热后的冷却液在换热模块中散热冷却,冷却液不发生相变; 两相冷板式液冷利用液泵驱动冷却液进入冷板,吸热后蒸发成气态,然后通过冷凝系统捕获该气体,冷凝系统再将气体冷凝为液体,由于两相冷却液可以产生液态和气态两种状态,因此称为两相冷板式液冷。

相比热管、VC、3DVC等风冷技术,冷板式液冷在热传递性、可靠性、功率密度等方面更具优势,具备更高的散热效率,散热范围的上限可超过1000W。不仅如此,与风冷相比,冷板式液冷虽然初期建设成本目前更高,但其拥有更低的P U E,全液冷相较风冷节能高达90%以上,用电成本更低;此外,冷板式液冷还具备更低的改造成本。长期来看,冷板式液冷具备更高的长期经济效益。

正是由于液冷相比风冷优势显著,英伟达最新一代GPU B200就采用液冷散热技术取代了以往的风冷散热方案。英伟达创始人兼CEO黄仁勋认为,液冷技术将为未来发展趋势,并有望引领整个散热市场进行变革,从B200开始,英伟达以后所有产品都将采用液冷散热技术。在英伟达这个龙头带动的作用下,相信冷板式液冷在服务器芯片级散热领域的应用将更加广泛。

随着AI大模型加速发展,AI服务器的市场规模持续扩大,必然带动服务器芯片出货量强劲增长。据Precedence预测,2026年全球AI芯片市场规模477亿美元,2024-2026年的年复合增长率为29.72%。分析认为,AI服务器及芯片市场规模扩大, 且芯片功耗增长提高散热要求,芯片级散热市场规模增速有望持续提升,而冷板液冷作为服务器芯片级散热的未来方向,市场高增长可期。

服务器、机柜、机房级散热需求同步增长

除芯片级散热外,数据中心温控系统还包含服务器级、机柜级和机房级三个层级的散热,四个层级的散热器件或设备共同作用、相互配合,共同构成完善的数据中心温控系统。在生成式AI拉动算力需求持续攀升的背景下,服务器级、机柜级和机房级散热需求将同步增长。

图:数据中心温控系统框架

图片来源:国海证券研报

服务器层级的散热也包含风冷散热与液冷散热两种。其中服务器层级的风冷散热主要采用风扇+热管/VC/3D VC相结合的散热方案,其主要特点是简单、 成熟和成本相对较低,通常用于功率密度较低的数据中心环境。 然而,随着服务器功率密度的增加和对能效要求的提高,风冷系统的局限性开始显现,因为在高功率密度环境下,空气的热传导性能可能不足以高效地散热,导致系统效率降低和运营成本增加。

服务器层级的液冷散热可分为冷板式液冷散热和浸没式液冷散热。冷板式的服务器一般是风冷和液冷组合,通过冷媒流通冷板带走约50%-80%的热量,剩余热量由风冷带走。目前,冷板式液冷服务器平均价格或高于风冷服务器,但随着其渗透率提升,服务器厂商有望实现量价齐升与盈利水平的增长。据IDC报告,中国液冷服务器市场中,冷板式占到了90%左右。

浸没式液冷是将整个服务器或其组件直接浸入液体冷却剂中的冷却方式。浸没式液冷服务器通过对服务器进行了外壳设计、主板改造、散热系统升级、密封性等多重改造等,使液体完全包围服务器元件,实现更加高效地吸收和散发热量。长远来看,浸没式在散热效率和单机柜功率、空间利用率等方面比冷板式具有显著优势。

和服务器一样,机柜级散热也包括风冷与液冷两种方式。其中,风冷机柜主要由机柜内部风扇/热管系统进行散热, 在机柜内部形成冷热空气的循环,从而降低服务器等ICT设备的运行温度。冷板式液冷机柜系统配备CDU等设施进行散热,也会采取风冷+液冷混合的模式,如英伟达的GB200 NVL72的液冷机架系统就是选取冷板式液冷进行散热。除冷板式液冷机柜外,单相浸没式机柜、双相浸没式机柜也都是机柜级液冷散热的重要方向。

机房级散热仍包括风冷机房和液冷机房。其中风冷机房主要依赖空调系统对机房内部进行制冷,降低机房温度;液冷机房也包括冷板式液冷机房和浸没式液冷机房。虽然目前冷板式液冷机房技术更为成熟,但浸没式液冷机房体现出了更高的市场潜力。根据赛迪数据,2023-2025年,浸没式液冷数据中心市场规模年复合增长率有望达到38%,高于冷板式的26%。

节能降碳政策助液冷散热加速推广

据中国能源报,2022年全国数据中心耗电量达到2700亿千瓦时,占全社会用电量约3%。随着生成式AI带来全社会算力持续提升,预计数据中心用电量占全社会用电量的比重还将越来越高。数据中心已成为全球经济发展的能耗大户,节能降碳迫在眉睫,打造绿色算力是未来算力发展的重中之重。

据相关统计,2022年我国在用数据中心平均PUE为1.52,并且有相当数量的数据中心PUE仍超过1.8甚至2.0。而根据政策要求,全国新建大型、超大型数据中心平均PUE应降到1.3以下, 要求集群内PUE要求东部降到1.25及以下,西部降到1.2及以下。随着政策的逐步落地,下游行业对液冷技术的认可度提升,液冷散热渗透率有望持续提升。

公开信息显示,传统风冷技术存在密度低、散热能力差、易形成局部热点、机械能耗大等缺陷;相比而言,液冷方式则以液体为介质进行散热,由于液体的体积比热容是空气的1000-3500倍,液体的对流换热系数是空气的10-40倍,在同等空间下,液冷的冷却能力远高于风冷。

据赛迪顾问统计数据,中国数据中心主要设备能耗占比中,制冷耗电占比(约43%)位居第二,仅次于IT设备自身能耗占比(约45%)。如果采用液冷技术替代大部分空调系统、风扇等高能耗设备,可实现节能20%-30%以上。此外,除了制冷系统自身能耗降低外,采用液冷散热技术有利于进一步降低芯片温度,芯片温度降低带来更高的可靠性和更低的能耗,整机能耗预计可降低约5%。

总体来看,液冷技术具有更佳的节能效果,可将液冷数据中心的PUE降至1.2以下,每年节省大量电费,大幅降低数据中心运行成本。相比于传统风冷,液冷散热技术的应用虽然会增加一定的初期投资,但可通过降低运行成本回收投资。

正因液冷散热节能降碳优势明显,我国三大运营商2023年联合发布的液冷技术白皮书提出,到2025年,50%以上数据中心项目应用液冷技术,共同推进形成标准统一、生态完善、成本最优、规模应用的高质量发展格局。

据浪潮信息测算,到2025年,液冷数据中心渗透率有望达到20%以上, 其表示基本上所有的运营商,银行在新建的数据中心规划了液冷,真正的建设应该会在2024年初大量开启。

奇鋐、飞荣达等优质散热厂商有望成为大赢家

在AI和数字经济大发展的背景下,近年来我国服务器及数据中心的规模持续增长,与之相关的散热产品市场也越来越大,吸引了大量企业投身到该领域。不过,在服务器或数据中心散热领域做得更好的仍是奇鋐科技、双鸿科技、飞荣达、维谛科技、英维克等老牌专业散热厂商,这些企业未来有望成为大赢家。

奇鋐科技:总部位于台湾的奇鋐科技是全球领先整体热解决方案提供商,主要产品为散热器、散热片、风扇、3DVC、冷板式液冷等,是英伟达的散热产品的主力供应货之一。英伟达G B 2 0 0首度采用液冷散热,将推升供应链产品平均售价提升,奇鋐科技有望成为最大的受益者之一。

双鸿科技:双鸿科技也是全球领先的散热方案提供商,散热产品及方案广泛应用于消费电子、PC、服务器等领域。在服务器散热领域,双鸿科技于2023年顺利量产了冷板式液冷产品,CDU也于当年完成了小批量出货。双鸿科技认为,在新一代 AIGPU的带动下,到2024年第二季度,服务器散热领域的液冷需求需求将高于风冷。

飞荣达:位于中国深圳的飞荣达深耕散热和电磁屏蔽领域近30年,是行业领先的散热及电磁屏蔽提供商,公司2023年散热产品贡献营收17.3亿元,占公司总营收的40%。截至目前,飞荣达散热产品及解决方案已广泛应用到消费电子、服务器、AIPC、新能源等领域,客户包括华为、三星、苹果、荣耀、小米等。在服务器散热领域,飞荣达可提供芯片级、服务器级、机柜级等多种类型的液冷或风冷产品,其中,新开发的液冷散热模组已获得大客户认可。截至目前,飞荣达已积累了大量服务器领域的客户资源,包括华为、中兴、微软、思科、浪潮、新华三、超聚变、神州鲲泰及Facebook、google等。

除上述企业外,维谛科技、摩丁制造、英维克、曙光数创、高澜股份等都是服务器或数据中心散热领域的有力竞争者。

图片来源:企业供稿

本网站所有内容属北京商报社有限公司,未经许可不得转载。 商报总机:010-64101978 媒体合作:010-64101871

商报地址:北京市朝阳区和平里西街21号 邮编:100013 法律顾问:北京市中同律师事务所(010-82011988)

![]()

网上有害信息举报 违法和不良信息举报电话:010-84276691 举报邮箱:bjsb@bbtnews.com.cn

网上有害信息举报 违法和不良信息举报电话:010-84276691 举报邮箱:bjsb@bbtnews.com.cn

ICP备案编号:京ICP备08003726号-1  京公网安备11010502045556号 互联网新闻信息服务许可证11120220001号

京公网安备11010502045556号 互联网新闻信息服务许可证11120220001号